IBM a commercialisé en 2023 un ordinateur quantique de 127 qubits, le Eagle, accessible via le cloud. Google, de son côté, revendique une suprématie quantique depuis 2019, bien que les débats persistent sur la portée réelle de cette avancée. Les prototypes opérationnels restent rares et centralisés dans quelques centres de recherche ou entreprises privées. La fiabilité et la performance de ces machines varient fortement selon les architectures et les usages. Les acteurs industriels, tout en multipliant les annonces, peinent encore à proposer un produit standardisé ou disponible à grande échelle.

Panorama actuel de l’informatique quantique : avancées et défis majeurs

Le calcul quantique est devenu l’arène de la nouvelle course à la puissance informatique. IBM, Google, Microsoft, Honeywell, NIST et Nvidia se livrent à une bataille de géants, chacun déployant des moyens colossaux pour faire surgir la première génération d’ordinateurs quantiques exploitables. De Paris à Montréal, la France et le Canada accélèrent le tempo sous l’impulsion d’investissements massifs, tandis que l’Europe s’organise autour de coalitions publiques et privées pour structurer ses ambitions.

Au cœur de cette effervescence, une promesse : traiter des problèmes complexes hors de portée de nos supercalculateurs classiques. Mais l’état réel des technologies révèle un paysage fragmenté. Les machines actuellement disponibles reposent principalement sur deux grandes familles d’architectures :

Les entreprises et laboratoires travaillent aujourd’hui avec des solutions qui se distinguent notamment par :

- qubits supraconducteurs

- atomes neutres

À chaque technologie ses avantages, mais aussi ses contraintes. Les prototypes de Google et IBM atteignent la barre symbolique des centaines de qubits physiques. Pourtant, l’industrialisation demeure freinée par un taux d’erreur encore trop élevé. La correction d’erreurs quantiques s’impose comme le nerf de la guerre, mobilisant les meilleurs cerveaux pour stabiliser les qubits logiques et fiabiliser les calculs.

La recherche avance sans relâche, animée par la diversité des approches. Entre qubits topologiques, photons et ions piégés, chaque piste cherche à renforcer la robustesse et la reproductibilité sans qu’aucune ne s’impose comme solution universelle. Le défi est clair : transformer des prototypes isolés en technologies quantiques industrielles, reproductibles et accessibles. Prenons le cas de la correction d’erreurs : sans maîtrise à ce niveau, la puissance annoncée reste dans les limbes, prisonnière de la décohérence et d’une instabilité chronique.

Quelles applications concrètes pour les entreprises aujourd’hui ?

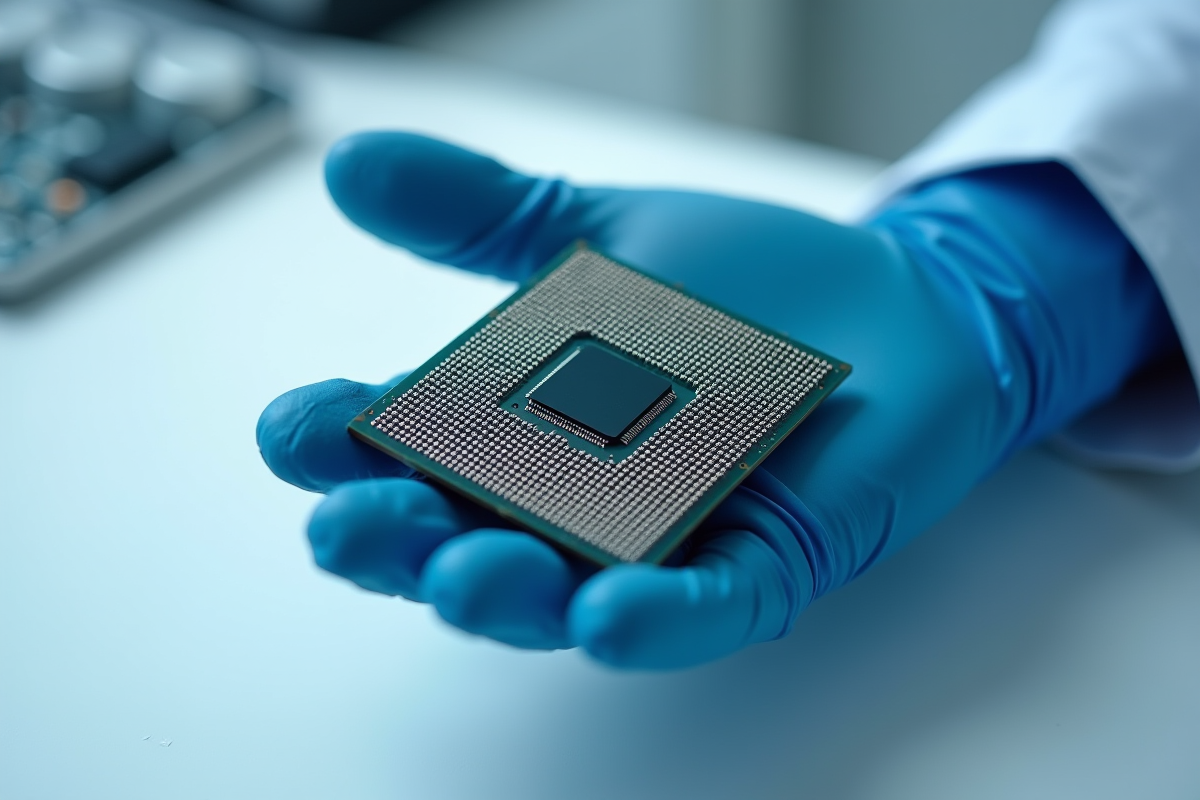

Derrière les annonces fracassantes, le calcul quantique s’expérimente déjà dans certains secteurs pionniers. Les grandes entreprises de la pharmacie, de la finance ou de la logistique s’aventurent sur ce terrain, souvent à travers des programmes pilotes menés avec prudence. Acquérir un ordinateur quantique prêt à l’emploi reste hors de portée : l’accès se fait exclusivement par le cloud, sous l’égide d’acteurs tels que IBM, Google ou Amazon. Leurs plateformes ouvrent la porte à des expérimentations, offrant la possibilité de confronter les algorithmes quantiques aux performances des supercalculateurs classiques.

Le secteur bancaire s’empare de la simulation de portefeuilles complexes, l’industrie explore la modélisation moléculaire, et la cybersécurité prépare la transition vers la cryptographie post-quantique. Les avancées restent modestes, freinées par la fiabilité limitée des qubits physiques actuels. Pourtant, chaque percée dans le développement d’algorithmes quantiques rapproche un peu plus l’industrie d’un basculement. À Paris, des start-up telles que Pasqal ou Quandela s’associent à de grands groupes pour façonner des solutions adaptées : optimisation logistique, analyse prédictive sur des volumes massifs de données, simulation de matériaux innovants, ou encore machine learning hybride.

Quelques cas d’usage se dessinent déjà, illustrant les premiers bénéfices visés par ces nouvelles machines :

- Big data : analyse de volumes de données colossaux, détection de corrélations inédites

- Intelligence artificielle : accélération des phases d’entraînement des modèles

- Gestion des risques financiers : évaluation et optimisation de scénarios complexes

L’ordinateur quantique universel et fiable reste une perspective. Mais la dynamique industrielle s’intensifie. Les collaborations public-privé gagnent en maturité, les projets pilotes se professionnalisent. Prenons l’exemple du IQM Spark, désormais en service dans plusieurs laboratoires européens : ce système marque une étape décisive vers une informatique quantique orientée usage, même si l’on demeure encore dans une phase de tests encadrés.

Les acteurs incontournables et leurs prototypes : tour d’horizon des offres disponibles

Sur le front de l’informatique quantique, la rivalité s’aiguise. IBM joue cartes sur table, s’appuyant sur une feuille de route ambitieuse et des machines accessibles à distance. Son Quantum System Two incarne une avancée notable : il combine plusieurs processeurs, franchissant le cap des 1000 qubits physiques et ouvrant de nouvelles perspectives. L’accès distant à ces prototypes permet aux entreprises de tester en conditions réelles des algorithmes quantiques sur des architectures de plus en plus stables, appuyées par la correction d’erreurs.

Google, dans la course, se targue d’avoir démontré la « suprématie quantique » avec son prototype Sycamore, 53 qubits, mais une prouesse technique saluée et discutée par les spécialistes. La firme concentre aujourd’hui ses efforts sur la correction d’erreurs quantiques, étape clé pour faire passer la technologie de la salle blanche à l’outil de production.

Côté européen, la France avance avec Pasqal, qui mise sur les atomes neutres. Cette technologie, jugée prometteuse pour augmenter le nombre de qubits, bénéficie de transferts de savoir-faire via des partenariats industriels solides. En parallèle, Honeywell et le NIST parient sur les ions piégés, tandis que Microsoft poursuit la voie du qubit topologique, une approche encore expérimentale.

Le marché voit donc coexister une multitude de prototypes, chacun incarnant une stratégie différente, qubits supraconducteurs, atomes neutres, ions piégés. Cette diversité alimente un écosystème en ébullition, offrant aux entreprises une gamme d’options pour s’initier au quantique, en attendant l’arrivée d’un ordinateur quantique fiable et universel.

Choisir un ordinateur quantique fiable : critères essentiels et perspectives d’évolution

Mettre la main sur un ordinateur quantique fiable suppose d’examiner une série de critères aussi bien techniques que stratégiques. La stabilité des qubits physiques reste le point de passage obligé. Sans une maîtrise réelle du taux d’erreur, impossible d’envisager le traitement de calculs complexes à grande échelle. Les meilleurs prototypes affichent aujourd’hui des taux proches de 0,1 %, mais ces performances s’effritent dès que l’on monte en volume ou que l’on ambitionne d’utiliser des qubits logiques issus de la correction des erreurs quantiques.

Les plateformes d’IBM et de Google donnent accès à des machines via le cloud, ce qui permet d’éprouver la fiabilité en conditions concrètes, bien loin des effets d’annonce. Les entreprises gagnent donc à examiner précisément la nature des accès proposés, la documentation sur la technologie quantique utilisée, et la présence de solutions de gestion des erreurs.

Avant de s’engager, il convient d’observer plusieurs paramètres déterminants :

- Nombre de qubits réellement utilisables et stabilité des états quantiques

- Architecture retenue : supraconducteurs, atomes neutres, ions piégés

- Capacités de correction d’erreurs quantiques intégrées

- Qualité de l’écosystème logiciel et disponibilité du support technique

L’autre variable, c’est la vitesse de l’innovation. Ce qui semble pertinent aujourd’hui risque d’être dépassé demain, tant la recherche et les investissements se multiplient. Les initiatives européennes, du côté de la France et du Canada, rivalisent d’ingéniosité pour proposer des offres taillées sur mesure pour l’industrie. Les analyses de cabinets comme Gartner ou les études d’Olivier Ezratty permettent de prendre le pouls de la maturité réelle du secteur. À ce stade, la prudence reste de mise : le marché est saturé de promesses, mais chaque jalon posé précipite le quantique vers la réalité industrielle.

L’informatique quantique trace déjà son sillage, entre espoirs et expérimentations. Le jour où un ordinateur quantique fiable s’imposera dans les entreprises ne relève plus de la science-fiction : il s’agit désormais d’une question de tempo, d’audace, et de persévérance collective.